Локальный AI для кода: бесплатный стек Goose + Ollama + Qwen3

Как заменить облачные платные инструменты вроде Claude Code и Codex локальным, бесплатным стеком из Goose, Ollama и Qwen3 и получить «инженерный отдел в коробке».

Как заменить облачные платные инструменты вроде Claude Code и Codex локальным, бесплатным стеком из Goose, Ollama и Qwen3 и получить «инженерный отдел в коробке».

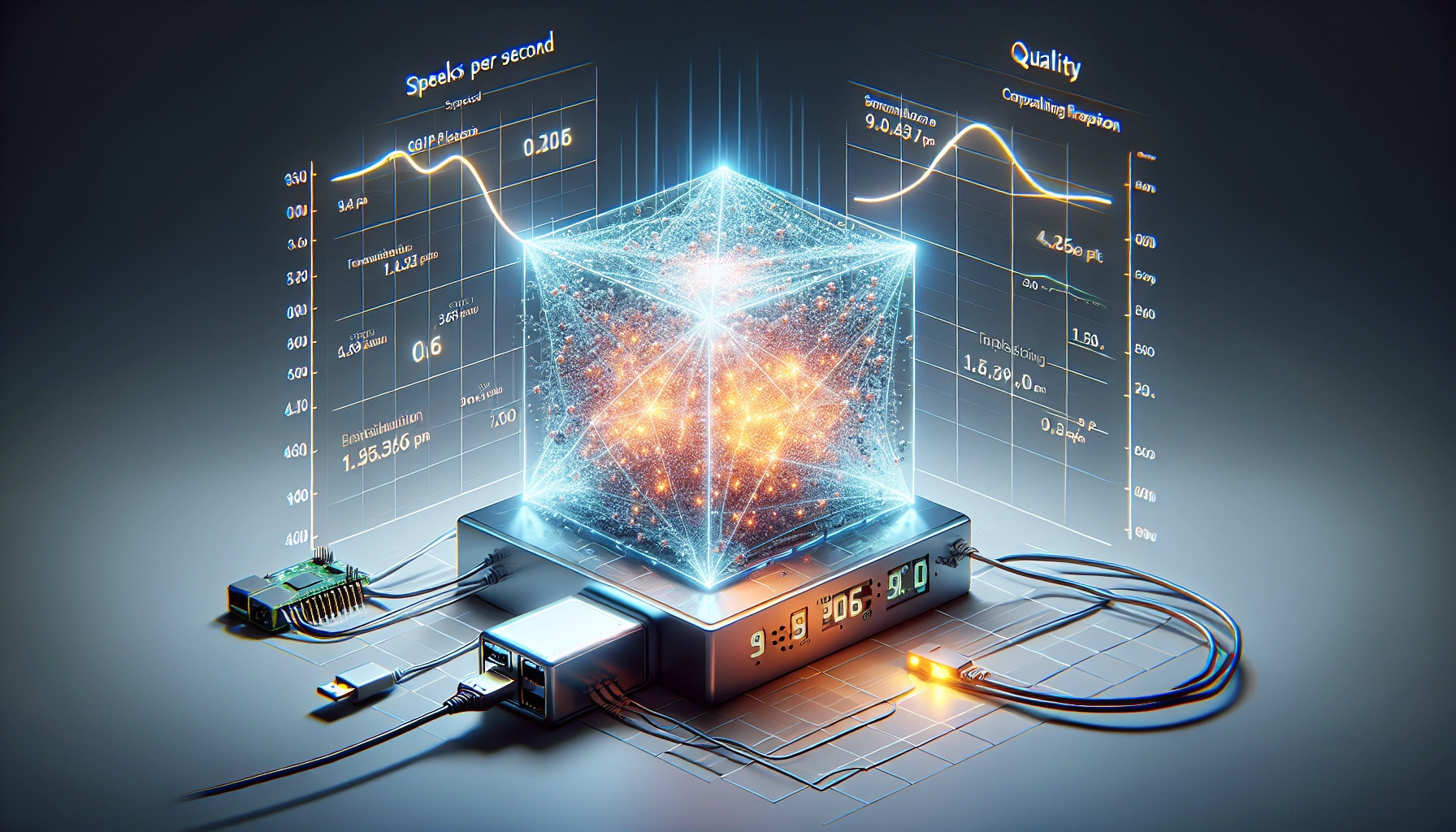

Как ByteShape с помощью ShapeLearn научили Qwen3‑30B работать в реальном времени на Raspberry Pi 5, Intel i7 и современных GPU, не жертвуя качеством ради бессмысленной экономии битов.

Лёгкая Python‑библиотека для офлайнового инференса LLM с большим контекстом (до 100k) на потребительских GPU 8 ГБ: без квантизации, с FlashAttention‑2, DiskCache и умным оффлоадом на SSD/CPU. Поддержка моделей Qwen3, Llama 3 и gpt‑oss, установка через pip.