Квадратный счёт: как кэш‑чтения растут вместе с контекстом

Почему при длинных разговорах кэш‑чтения начинают «съедать» бюджет и что с этим можно сделать.

Почему при длинных разговорах кэш‑чтения начинают «съедать» бюджет и что с этим можно сделать.

История про то, как текстовая модель получила «глаза»: MCP-сервер, Google Lens, OpenCV и умение распознавать объекты без ключей API.

История эксперимента с «командой агентов» Claude: от бесконечного цикла до 100 000‑строчного компилятора, который собирает Linux 6.9.

Криминальная операция «Bizarre Bazaar» торговала доступом к плохо защищённым LLM-эндпойнтам: майнинг, перепродажа API и кража данных. Исследование Pillar Security показывает этапы атаки и работу коммерческой экосистемы вокруг сервиса SilverInc/NeXeonAI.

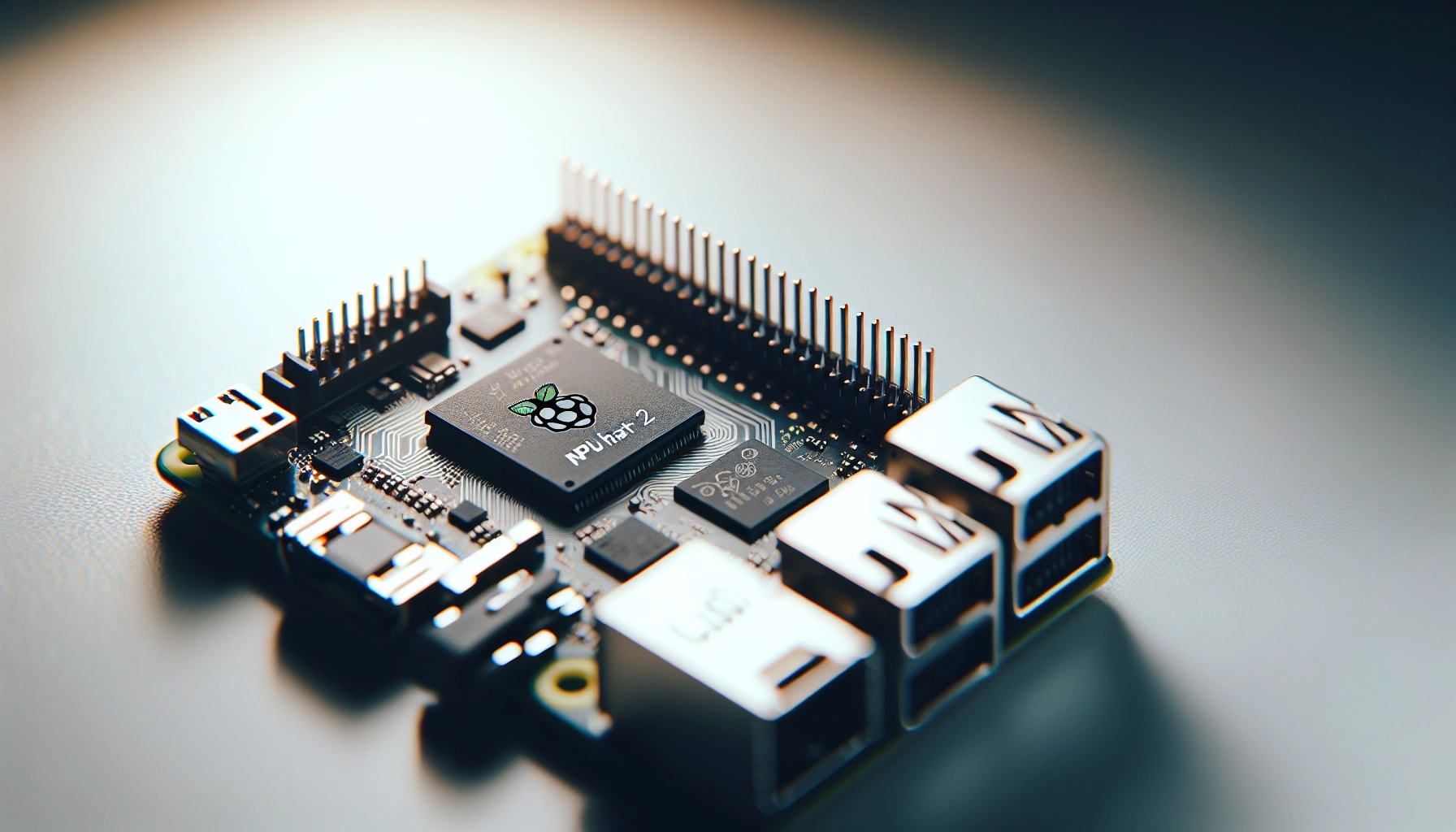

Raspberry Pi выпустила AI HAT+ 2 с чипом Hailo 10H и 8 ГБ LPDDR4X — формально это мечта для локальных LLM и компьютерного зрения, но на практике HAT оказывается нишевым инструментом: CPU Raspberry Pi 5 быстрее в большинстве задач, а по части LLM выгоднее просто взять плату с 16 ГБ ОЗУ. Зато в энергосберегающих сценариях, где нужно и зрение, и немного ИИ‑логики в одном компактном модуле, у новинки есть своё место.