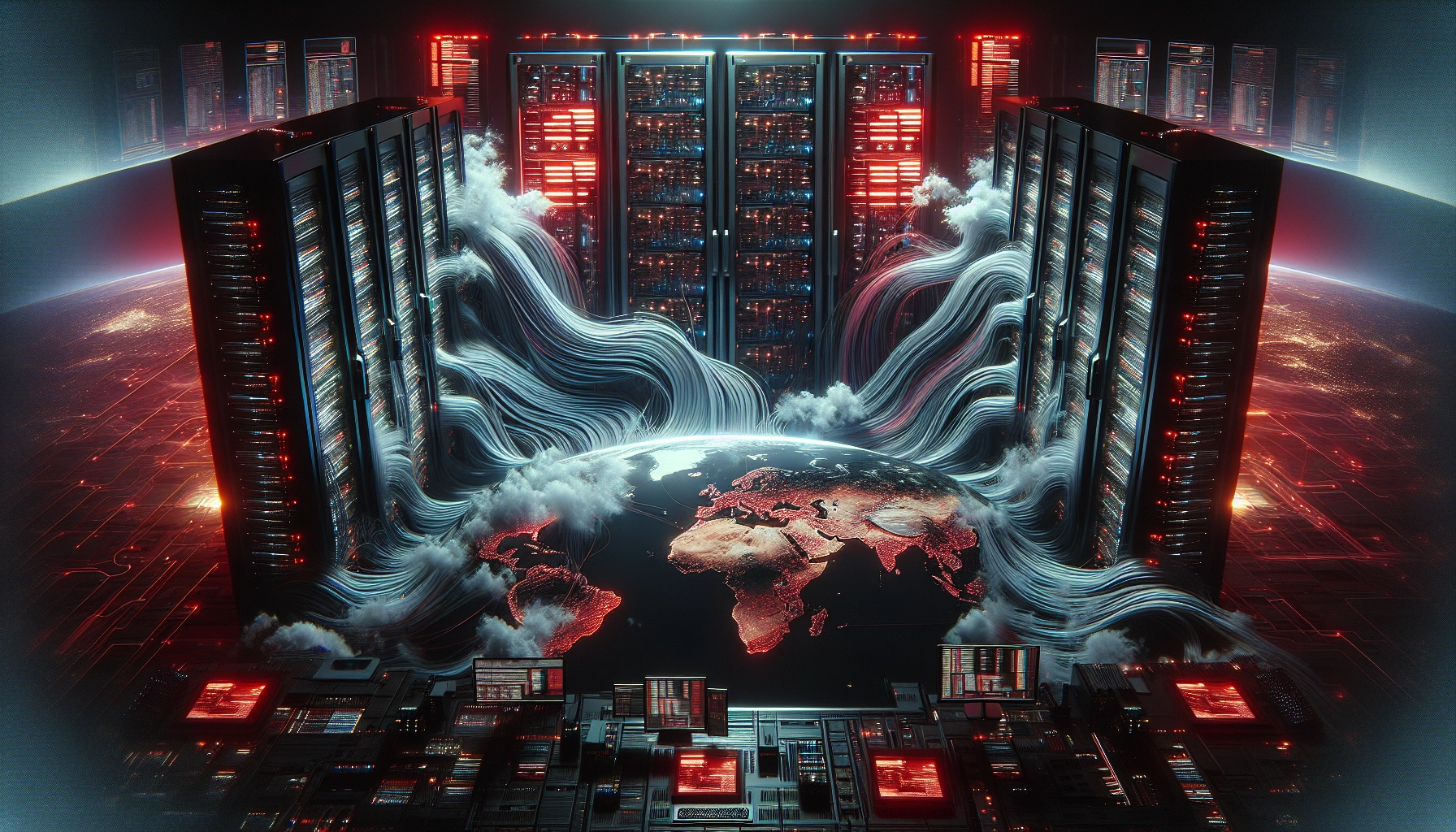

Экстренный патч против React2Shell уронил почти треть трафика Cloudflare

Cloudflare объяснила утренний сбой экстренными митигациями против критической уязвимости React2Shell в React Server Components. Ошибка в логике парсинга тела запросов обернулась 500-ми ошибками для примерно 28% HTTP-трафика. Уязвимость (CVE-2025-55182) затрагивает ветку React 19 и уже активно эксплуатируется.